Zusammenfassung des Fachartikels

Bei der Durchführung von technischen Passwort-Audits waren wir bislang in der Lage, über 40.000 Passwort-Hashes von Mitarbeitern zu analysieren und davon mehr als drei Viertel zu knacken. Dies ist in der Regel auf die Auswahl kurzer Passwörter, einer veralteten Passwortrichtlinie im Unternehmen sowie der hohen Wiederverwendung von Passwörtern zurückzuführen. Weiterhin kommt es oftmals vor, dass administrative Nutzer nicht an die unternehmensweite Passwort-Richtlinie gebunden sind und daraufhin schwache Passwörter wählen. Ebenfalls können prozessuale Probleme bei dem Onboarding von Mitarbeitern bestehen, die aktiv von einem Angreifer ausgenutzt werden können, um Passwörter zu knacken. Oftmals genügt ein richtiges Passwort eines privilegierten Nutzers, um ein Unternehmen vollständig kompromittieren zu können.

Beauftragen Sie einen Active Directory Passwort-Audit, um die Widerstandfähigkeit Ihres Unternehmens gegen Angreifer im internen Netzwerk zu erhöhen bzw. die Effektivität Ihrer Passwort-Richtlinien zu verifizieren. Gerne unterstützen wir Sie dabei, Probleme im Umgang mit Passwörtern und den dazugehörigen Prozessen zu identifizieren und zu beheben.

Einleitung

Die Corona-Pandemie sorgte für einen plötzlichen Wechsel vieler Mitarbeiter in das Home-Office. IT-Infrastrukturkomponenten, wie beispielsweise eine VPN-Lösung und entsprechende Mitarbeiterzugänge, für den Zugriff von Zuhause auf Unternehmensressourcen, waren jedoch nicht immer zu Beginn des Arbeitsplatzwechsels vorhanden. Viele Unternehmen mussten diese Lösungen erst nachreichen und den Aufbau ihrer IT-Infrastruktur überdenken bzw. nachrüsten.

Neben den neu dazugewonnenen IT-Infrastrukturkomponenten, die nun in der Regel öffentlich aus dem Internet erreichbar sein müssen, erhielten Mitarbeiter oftmals auch neue Zugangsdaten für den Zugriff auf Dienste und Ressourcen. Falls technisch möglich, implementierten Unternehmen eine sogenannte Single-Sign-On (SSO) Authentifizierung, wodurch der Nutzer sich lediglich einmalig mit seinen Domänen-Zugangsdaten anmeldet und anschließend auf die verschiedensten Unternehmensressourcen als bereits angemeldeter Nutzer zugreifen kann.

Laut Professor Christoph Meinel, dem Direktor des Hasso-Plattner-Instituts, vergrößerte die Corona-Pandemie die Angriffsfläche für Cyberangriffe stark und stellte IT-Abteilungen vieler Unternehmen vor große Herausforderungen.[1] Aufgrund des Zuwachses an Home-Office-Tätigkeit, der verstärkten Internetnutzung seit der Pandemie sowie der Erweiterung von IT-Infrastrukturen bei Unternehmen erhielten Cyber Threat Actors neue, lukrative Ziele für Hacking- und Phishing-Angriffe. Allein der DE-CIX Internetknoten in Frankfurt, wo Datenströme verschiedenster Internetanbieter zusammenlaufen, verzeichnete im März 2019 einen neuen Rekordwert in Höhe von 9,1 Terabit in der Sekunde. Dieser Wert kann mit dem Datenvolumen von 1800 heruntergeladenen HD-Filmen in der Sekunde verglichen werden. Ein neuer Höchststand zu den bisherigen Spitzenwerten von 8,3 Terabit.[2]

Assume Breach

Die Auswirkungen der Corona-Pandemie erhöhen demnach seither die Angriffsoberfläche von Unternehmen und ihren Mitarbeitern gegenüber realen Cyber-Angriffen. Vermehrt tauchen Begriffe wie „Supply Chain Attacks“ und „0-Day Schwachstellen“ in den öffentlichen Medien auf, wobei Unternehmen aktiv angegriffen und kompromittiert werden. Oftmals reicht hierbei die Kompromittierung eines einzelnen Mitarbeiters oder IT-Systems aus, um Zugriff auf das interne Netzwerk eines Unternehmens zu erhalten. Hierbei können sich eine Vielzahl von Angriffen ereignen, wie zum Beispiel Phishing-Angriffe oder das gezielte Ausnutzen von Schwachstellen in öffentlichen IT-Systemen.

Bereits Microsoft operiert nach der „Assume Breach“ Haltung und geht eher davon aus, dass ein Angreifer bereits Zugriff erhalten konnte, als dass eine 100-prozentige Sicherheit vorherrsche. Doch was passiert eigentlich, wenn ein Angreifer Zugriff auf ein Unternehmensnetzwerk erhalten konnte? Wie ist es möglich, dass ein Angreifer einen normalen Mitarbeiteraccount kompromittiert und dadurch in der Lage ist, das vollständige Unternehmen lahmzulegen? Sensible Ressourcen und Serversysteme werden schließlich regelmäßig mit Sicherheitspatches bespielt und stehen nicht jedem frei zur Verfügung. Lediglich eine geringe Anzahl an Personen, wie Administratoren, besitzen Zugriff auf kritische Systeme. Weiterhin stellt eine unternehmensweite Passwortrichtlinie sicher, dass Angreifer die Passwörter von Administratoren und sonstigen Mitarbeitern nicht einfach erraten können. Wo liegt also das Problem?

IT-Sicherheit und Passwörter

Die alljährliche Statistik des Hasso-Plattner-Instituts aus dem Jahr 2020 [3] veranschaulicht erneut, dass die beliebtesten Passwörter der Deutschen abermals „123456“, „123456789“ oder „passwort“ lauten, wie bereits in den Statistiken aus den Vorjahren zuvor. Von einer ausreichend starken Passwortkomplexität ist hierbei nicht die Rede, geschweige denn davon, dass Passwörter nicht wiederverwendet werden.

Dieser Tatsache sind sich Unternehmen jedoch in der Regel bewusst und implementieren daraufhin technische Richtlinien, um dem Einsatz schwacher Passwörter vorzubeugen. Diese Regeln werden zum Beispiel mittels Gruppenrichtlinien über den Verzeichnisdienst Microsoft Active Directory für alle Mitarbeiter angewendet. Diese werden daraufhin gezwungen, Passwörter mit einer ausreichend starken Passwortlänge sowie gewissen Komplexitätsanforderungen zu wählen. Sätze wie „Ihr Passwort muss mindestens 8 Zeichen lang sein und mindestens ein Sonderzeichen oder eine Zahl enthalten“ kennt schließlich jeder. Somit gehören schwache Passwörter in heutigen Unternehmen der Vergangenheit an, oder? Leider nicht, denn ein Passwort wie „Winter21!“ ist noch immer schwach und erratbar, trotz Konformität zur unternehmensweiten Passwortrichtlinie.

Online-Angriffe vs. Offline-Angriffe

Für Online-Dienste wie Outlook Web Access (OWA) oder VPN-Portale, wo Nutzer sich mit Ihrem Nutzernamen und Passwort anmelden, ist die Gefahr eines erfolgreichen Angriffs in der Regel stark reduziert. Ein Angreifer müsste hierbei zuerst einen validen Nutzernamen identifizieren und anschließend das dazugehörige Passwort erraten. Weiterhin kommen oftmals technische Lösungen wie Account-Lockout nach mehrmaligen Fehlanmeldungen, eine Ratenlimitierung bei Login-Anfragen oder eine Zwei-Faktor-Authentifizierung (2FA) zum Einsatz. Diese Lösungen reduzieren die Erfolgschancen eines Angreifers erheblich, da nicht unendlich viele Rateversuche erfolgen können.

Doch selbst wenn solche Abwehrmechanismen nicht vorhanden sind, handelt es sich hierbei noch immer um einen Online-Angriff, bei dem der Angreifer ein Tupel aus Nutzernamen und Passwort wählt und diesen Rate-Versuch an den unterliegenden Server verschickt. Erst nach Verarbeitung der Anmeldeanfrage vom Server erhält der Angreifer das Ergebnis seines Passwort-Rate-Versuchs und entweder einen erfolgreichen Zugriff oder die Meldung über falsche Zugangsdaten. Diese Client-Server-Kommunikation schränkt die Performance eines Angreifers erheblich ein, da der Zeitaufwand und die Erfolgswahrscheinlichkeit eines Angriffs stark auseinanderdriften. Selbst ein einfaches Passwort, bestehend aus lediglich Kleinbuchstaben inkl. Umlauten und einer Länge von 6 Zeichen, würden 729 Millionen Serveranfragen eines Angreifers benötigen, um alle möglichen Passwortkombinationen durchzutesten. Zusätzlich müsste ein Angreifer hierbei bereits den Anmeldenamen seines Opfers kennen oder zusätzlich erraten. Unter Verwendung einer unternehmensweiten Passwortrichtlinie, inklusive den oben aufgeführten Abwehrmechanismen, geht die Wahrscheinlichkeit eines Online-Brute-Force-Angriffs gegen Null.

Anders hingegen sieht es für sogenannte Offline-Brute-Force-Angriffe aus, bei denen ein Angreifer typischerweise in den Besitz eines sogenannten Passwort-Hashes gelangt und diesen deutlich performanter mit seinen Passwort-Rateversuchen angreifen kann. Doch woher kommen diese Passwort-Hashes und warum sind diese anfälliger gegenüber Rateversuchen?

Passwort-Hashes

Lassen wir uns auf ein Gedankenspiel ein. Als großer Autoliebhaber sind wir, Max Muster, stets auf der Suche nach neuen Angeboten auf dem Automarkt. Dank des digitalen Wandels stehen uns nicht nur lokale Autohäuser und Makler zur Verfügung, sondern das gesamte Internet mit seiner Vielfalt an Suchplattformen, Webshops und Portalen. Von diesen Plattformen nehmen wir gerne Gebrauch und freuen uns darüber, mit einer einfachen Websuche viele interessante Angebote und Autoraritäten ergattern zu können. Für die Benutzung dieser Onlinedienste ist in der Regel ein Nutzerkonto erforderlich, um Favoriten abspeichern und Angebote abgeben zu können. Eine Registrierung mittels E-Mail und dem Passwort „Muster1234“ ist jedoch schnell erledigt. Doch wie funktioniert eine nachträgliche Anmeldung mit unserem neuen Nutzer eigentlich? Als Laie käme man schnell auf die Idee, dass der Anmeldename und das Passwort eines Nutzers einfach vom Dienstleister abgespeichert wird und beim Versuch der Anmeldung ein Abgleich stattfindet.

Dies ist generell gesprochen korrekt, jedoch fehlen der Vollständigkeit halber ein paar technische Details. Die Zugangsdaten werden korrekterweise bei der Registrierung abgespeichert und zwar in einer Datenbank. Die Datenbank enthält hierbei heutzutage jedoch nicht mehr das Klartextpasswort eines Nutzers, sondern einen sogenannten Passwort-Hash. Der Passwort-Hash wird mittels einer mathematischen Einwegfunktion aus dem Klartextpasswort des Nutzers errechnet. Anstelle unseres Passwortes „Muster1234“ steht in der Datenbank nun eine Zeichenkette wie „VEhWkDYumFA7orwT4SJSam62k+l+q1ZQCJjuL2oSgog=“ und die mathematische Funktion stellt hierbei sicher, dass diese Berechnung lediglich in eine Richtung („Einweg“) funktioniert. Aus der Zeichenkette ist es demnach nicht einfach möglich, erneut auf das Klartextpasswort zu schließen. Diese Methode stellt sicher, dass der Seitenbetreiber oder ein Angreifer mit Zugriff auf die Datenbank nicht einfach die Passwörter von Kunden im Klartext auslesen kann.

Bei einer Anmeldung wird nun das Klartextpasswort nach der Eingabe in der Loginmaske an den Anwendungsserver verschickt, welcher die Eingabe erneut in die mathematische Funktion einspeist und das Ergebnis mit dem abgespeicherten Passwort-Hash in der Datenbank abgleicht. Stimmen die Werte überein, so wurde das korrekte Passwort übermittelt und der Nutzer wird angemeldet. Unterscheiden sich die Werte, so wurde ein falsches Passwort übermittelt und der Nutzer erhält eine Fehlermeldung. Weiterhin kommen zusätzliche technische Gegebenheiten hinzu, wie die Replikation von Datenbanken, der Einsatz von “salted” Passwort-Hashes und vieles mehr. Für unser Gedankenspiel jedoch nicht weiter relevant.

Ein Angreifer, der nun versucht unser Nutzerkonto zu kompromittieren, steht erneut vor den Hürden eines Online-Angriffs. Der Anbieter der Suchplattform erlaubt z.B. lediglich drei Fehlanmeldungen, bevor das Nutzerkonto für 5 Minuten gesperrt wird. Ein automatisierter Angriff zum Erraten unseres Anmeldepasswortes ist demnach zeitlich nicht zu bewerkstelligen.

Anders sieht es jedoch aus, wenn ein Angreifer Lesezugriff auf die unterliegende Datenbank des Anbieters erhält, zum Beispiel mittels einer SQL-Injection-Schwachstelle in der Webanwendung. Nun ist der Angreifer in dem Besitz unseres Passwort-Hashes und kann auf Basis dessen einen Offline-Angriff durchführen. Die mathematische Einwegfunktion ist hierbei öffentlich bekannt und kann zur Berechnung herangezogen werden. Die Vorgehensweise eines Angreifers sieht nun wie folgt aus:

- Wahl einer beliebigen Input-Zeichenkette, welche den Rateversuch eines Passwortes widerspiegelt.

- Zeichenkette wird in die mathematische Einwegfunktion gespeist und der Passwort-Hash berechnet.

- Abgleich des errechneten Passwort-Hashes mit dem Passwort-Hash aus der echten Datenbank. Es folgt:

- Wenn identisch, wurde das Klartextpasswort erfolgreich erraten

- Wenn ungleich, wähle eine neue Input-Zeichenkette und starte erneut

Dieser Angriff ist deutlich performanter als Online-Angriffe, da hierbei keine träge Netzwerkkommunikation zwischen einem Client und einem Server erfolgen muss sowie Sicherheitsmaßnahmen wie 2FA, Ratenlimitierung oder Account Lockout nicht stattfinden. Jedoch gilt zu beachten, dass moderne und sichere Hashfunktionen in der Regel so ausgelegt werden, dass eine Hashberechnung für Angreifer ebenfalls aufwendig und nicht lukrativ ist. Hierbei wird der Aufwand einer einzelnen Hashberechnung um den Faktor n erhöht, welches für den einzelnen Abgleich eines Passwortes mit dem Hash in der Datenbank vernachlässigbar ist. Für einen Angreifer hingegen, der eine Vielzahl an Berechnungen seiner Passwort-Rateversuche benötigt, steigt der Aufwand jedoch erheblich um den Faktor n an, sodass ein erfolgreicher Passwort-Rateversuch mehrere Jahre benötigen würde. Unter der Verwendung moderner Hashfunktionen wie Argon2 oder PBKDF2 sind Offline-Angriffe demnach, ähnlich zu Online-Angriffen, eher komplex und zeitlich schwierig umzusetzen.

LM- und NT-Hashes

Unser Gedankenspiel können wir nun auf eine Vielzahl realer Anwendungsgebiete übertragen, wie zum Beispiel der Anmeldung an einem Windows-Betriebssystem. Ähnlich zu einem Nutzerkonto eines Online-Suchportals besteht unter Windows die Möglichkeit, Nutzer zu erstellen, die sich an dem Betriebssystem anmelden können. Für eine Anmeldung wird standardmäßig kein Passwort erfordert, kann jedoch für jeden Nutzer individuell konfiguriert werden. Ein Nutzerpasswort wird hierbei erneut als Passwort-Hash und nicht im Klartext abgespeichert. Microsoft verwendet hierbei zwei Algorithmen, um ein Nutzerpasswort in einen Hash umzuwandeln. Der ältere dieser beiden nennt sich LM-Hash und basiert auf dem bekannten DES-Algorithmus. Dieser wurde ab den Versionen Windows Vista bzw. Windows Server 2008 jedoch aus Sicherheitsgründen deaktiviert. Als Alternative wurde der sogenannte NT-Hash eingeführt, basierend auf dem MD4-Algorithmus.

Die Passwort-Hashes werden in einer so genannten SAM-Datenbank auf der Festplatte des Betriebssystems lokal abgelegt. Ähnlich zu unserem Gedankenspiel findet bei einer Windows-Anmeldung ein Abgleich zwischen dem Klartextpasswort der Nutzereingabe in den MD4-Algorithmus und dem abgelegten Passwort-Hash in der lokalen SAM-Datenbank statt. Sind die Hashes identisch, so wurde ein korrektes Passwort bei dem Anmeldeversuch übergeben und der Nutzer wird angemeldet.

Im Unternehmensumfeld und insbesondere in Microsoft Active Directory Umgebungen werden diese Passwort-Hashes neben weiteren Nutzerkennwerten und Objekten nicht nur lokal in einer SAM-Datenbank abgelegt, sondern ebenfalls auf einem dedizierten Server, dem Domain-Controller, in einer sogenannten NTDS-Datenbankdatei. Dies ist für eine einheitliche Authentifizierung gegenüber Datenbankserver, Dateiserver und sonstigen Ressourcen im Unternehmensumfeld mit Hilfe der Kerberos-Authentifizierung erforderlich. Weiterhin reduziert es die Komplexität bei einer Vielzahl von Mitarbeitern und IT-Assets im Unternehmen, da diese zentral an einer Stelle, dem Active Directory, verwaltet werden können. Mit Hilfe von Gruppenrichtlinien stellen Unternehmen zusätzlich sicher, dass Mitarbeiter ein Anmeldepasswort besitzen müssen und dieses auf einer strikten Passwort-Richtlinie basiert. Gegebenenfalls müssen Passwörter regelmäßig erneuert werden. Auf Basis dieses Domain-Nutzerpassworts können sich nun Single-Sign-On (SSO) Anmeldungen an vielen unterschiedlichen Unternehmensressourcen ereignen, da der NT-Hash des Passwortes zentral auf dedizierten Domain-Controllern aufbewahrt wird. Neben der lokalen SAM-Datenbank eines jeden Rechners und den Domain-Controllern einer on-premise Active Directory Umgebung steht ebenfalls die Möglichkeit zur Verfügung, die NT-Hashes eines Domain-Controllers mit der Cloud (z.B. Azure) zu synchronisieren. Hierdurch können auch SSO-Anmeldungen an Cloud-Assets, wie beispielsweise Office 365, realisiert werden. Die Passwort-Hashes eines Nutzers kommen demnach an vielen Stellen im Unternehmenskomplex zum Einsatz, welches die Wahrscheinlichkeit erhöht, dass diese entwendet werden können.

Zugriff auf NT-Hashes

Um als Angreifer Zugriff auf NT-Hashes erhalten zu können, gibt es eine Vielzahl an Möglichkeiten. Um diesen Fachartikel jedoch nicht unnötigerweise in die Länge zu ziehen, werden hier lediglich ein paar bekannte Wege aufgeführt:

- Kompromittierung eines einzelnen Mitarbeiterrechners (z.B. Phishing-E-Mail) und Auslesen der lokalen SAM-Datenbank des Windows Betriebssystems (z.B. mittels Mimikatz).

- Kompromittierung eines Domain-Controllers in der Active Directory Umgebung eines Unternehmens (z.B. mit Hilfe der PrintNightmare Schwachstelle) und Auslesen der NTDS-Datenbank (z.B. mittels Mimikatz).

- Kompromittierung eines privilegierten Domain-Nutzerkontos mit DCSync Berechtigungen (z.B. ein Domain Admin oder Enterprise Admin). Extrahierung aller NT-Hashes vom Domain-Controller einer AD-Domäne.

- Kompromittierung eines privilegierten Azure-Nutzerkontos mit Berechtigungen zur Durchführung einer Azure AD Connect-Synchronisierung. Extrahierung aller NT-Hashes vom Domain-Controller einer AD-Domäne.

- und viele weitere Angriffswege…

Passwort-Cracking

Nachdem NT-Hashes eines Unternehmens abgegriffen wurden, können diese entweder bei internen Angriffen „relayed“ werden oder ein Angreifer führt ein Passwort-Cracking durch, um an das Klartextpasswort eines Mitarbeiters zu gelangen.

Dies ist möglich, da NT-Hashes unter Windows und Active Directory Umgebungen einen veralteten Algorithmus namens MD4 verwenden. Diese Hashfunktion wurde 1990 von Ronald Rivest veröffentlicht und relativ schnell als unsicher befunden. Eine Hauptproblematik der Hashfunktion ist die fehlende Kollisionssicherheit, wodurch unterschiedliche Eingabewerte in die Hashfunktion zu dem gleichen Ausgabewert, dem Hash, führen. Dies unterwandert die Hauptaufgabe einer kryptologischen Hashfunktion.

Weiterhin ist die MD4-Hashfunktion äußerst performant und erschwert den Aufwand zur Hashberechnung, im Gegensatz zu modernen Hashfunktionen wie Argon2, nicht. Dies ermöglicht einem Angreifer, performante Offline-Angriffe gegen NT-Hashes durchzuführen. Ein moderner Gaming-PC mit aktueller Grafikkarte kann hierbei bereits zwischen 50-80 Milliarden Passwörter in der Sekunde berechnen. Das Knacken von kurzen oder schwachen Passwörtern wird hierdurch kinderleicht.

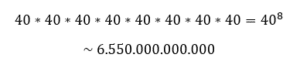

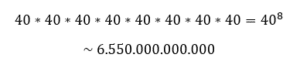

Um das Ausmaß dieser Geschwindigkeit zu verdeutlichen, gucken wir uns einmal die Anzahl aller möglichen Passwortkombinationen eines 8-stelligen Passwortes an. Hierbei nehmen wir der Einfachheit halber an, dass das Passwort lediglich aus Kleinbuchstaben sowie numerischen Werten besteht. Das deutsche Alphabet umfasst 26 Grundbuchstaben sowie die 4 Umlaute ä, ö, ü und Eszett ß. Numerische Werte bringen eine Auswahlmöglichkeit von 10 Werten mit, nämlich die Zahlen Null bis Neun. Das bedeutet, für jede Stelle unseres 8-stelligen Passwortes besitzt ein Nutzer 40 Auswahlmöglichkeiten. Dies entspricht ca. 6550 Milliarden Möglichkeiten bzw. der folgenden mathematischen Formel:

Ein Gaming-PC, der in der Sekunde 50 Milliarden Passwort-Rate-Versuche durchführen kann, würde demnach nur 131 Sekunden benötigen, um alle 6550 Milliarden Möglichkeiten unseres 8-stelligen Passwortes durchzutesten. Ein solches Passwort wäre demnach in etwas mehr als 2 Minuten gebrochen. Hinzu kommt, dass reale Threat Actors spezielle Passwort-Cracking-Systeme einsetzen, die zum Teil 500 bis 700 Milliarden Passwort-Rate-Versuche in der Sekunde erreichen. Solche Systeme kosten in der Anschaffung jedoch bereits deutlich über 10.000 EUR.

Weiterhin bestehen eine Vielzahl weiterer Cracking-Methoden, um Passwort-Hashes knacken zu können, die nicht darauf abzielen, den vollständigen Keyspace (alle Passwortmöglichkeiten) zu berechnen. Dadurch wird es möglich, auch Passwörter zu knacken, die mehr als 12 Zeichen besitzen und bei einem regulären Brute-Force-Angriff über den gesamten Keyspace mehrere Jahre erfordern würden.

Hierzu zählen unter anderem:

- Wörterbuchlisten (z.B. der deutsche Duden)

- Passwortlisten (z.B. aus öffentlichen Leaks oder Breaches)

- Regelbasierte Listen, Kombinationsangriffe, Keywalks, uvm.

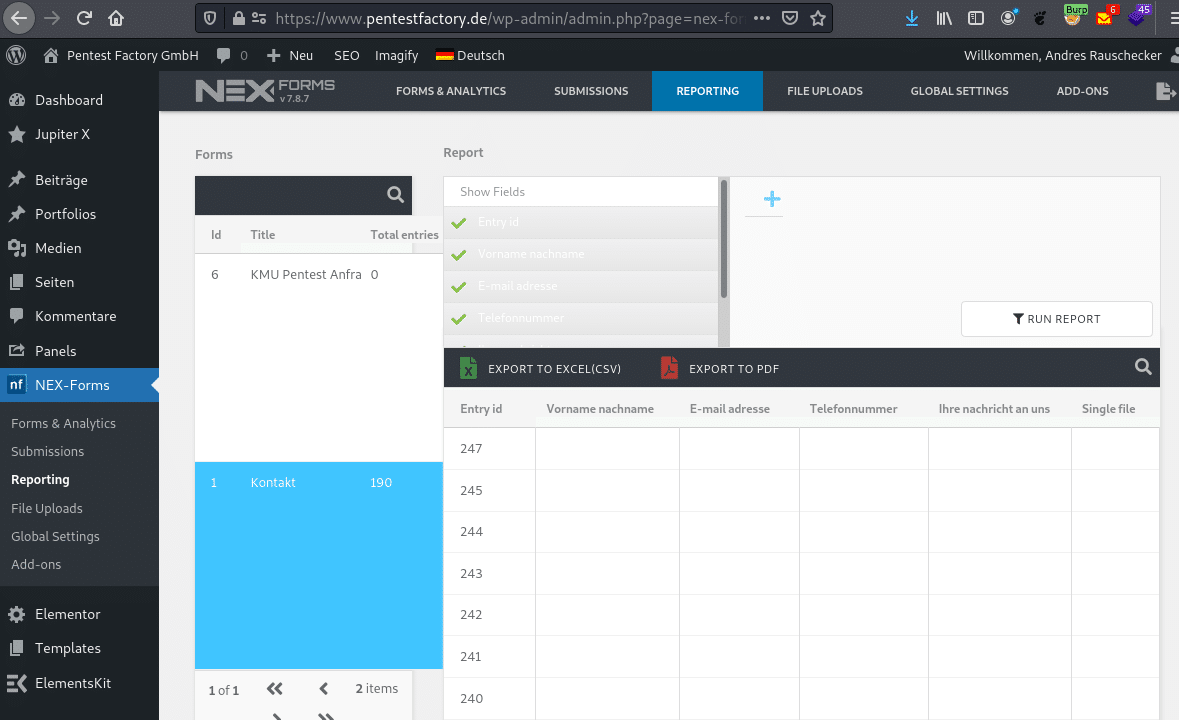

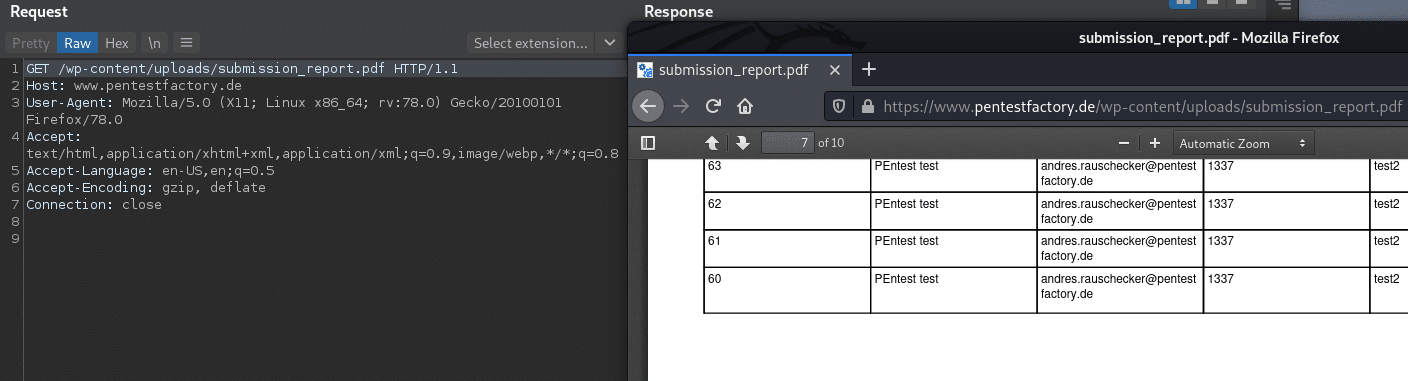

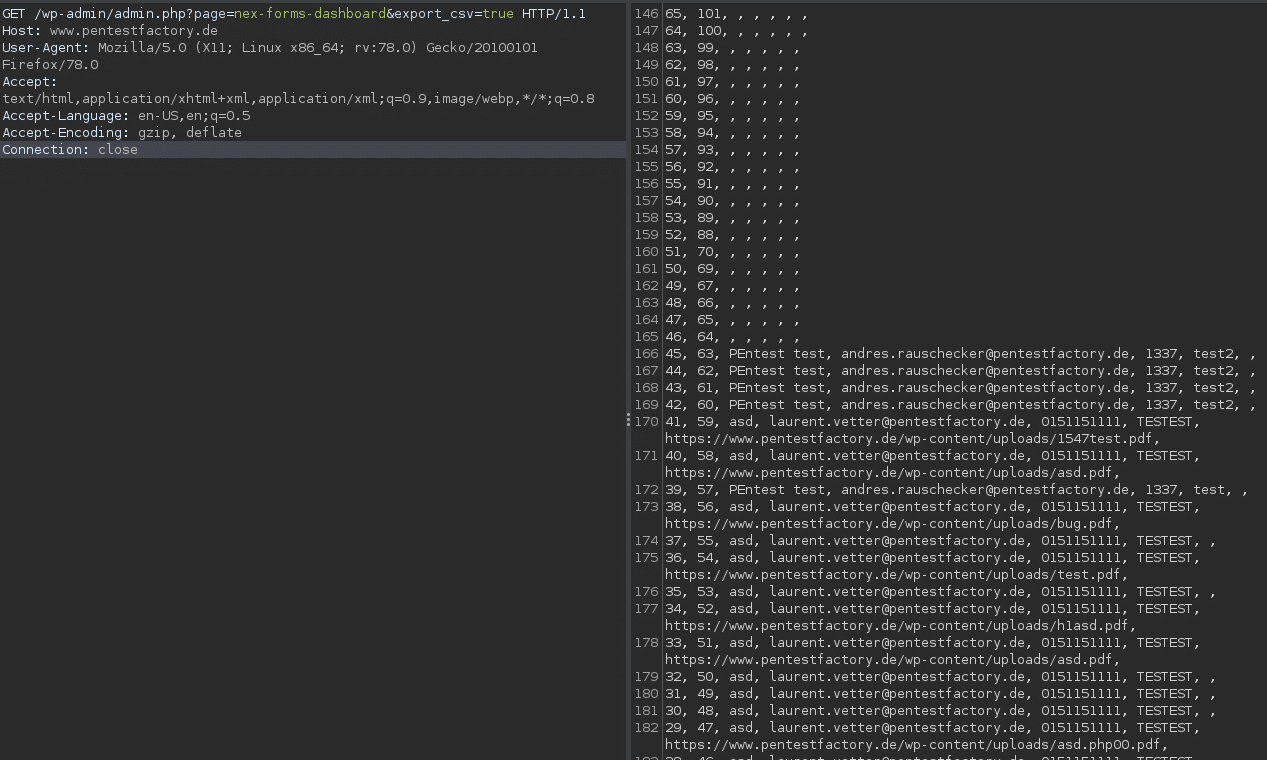

Pentest Factory Passwort-Audit

Mit der Beauftragung eines Active Directory Passwort-Audits führen wir genau solch ein Angriffsszenario durch. Im ersten Schritt extrahieren wir mit Ihnen zusammen alle NT-Hashes Ihrer Mitarbeiter von einem Domain Controller ohne Nutzerbezug. Unser Vorgehen wird hierbei mit Ihrem Betriebsrat abgestimmt und basiert auf einem erprobten Prozess.

Anschließend unterziehen wir die extrahierten Passwort-Hashes einem realen Cracking-Angriff, um die Hashes in ihre Klartextform, also dem realen Nutzerpasswort, zurückzuführen. Hierbei kommen eine Vielzahl moderner und realer Angriffsmethoden zum Einsatz, unter der Verwendung eines moderaten Cracking-Servers mit der Hash-Power von 100 Milliarden Rateversuchen in der Sekunde.

Nach Abschluss der Cracking-Phase bereiten wir die Ergebnisse für Sie auf und erstellen einen finalen Abschlussbericht. Dieser beinhaltet messbare Kennzahlen zu den kompromittierten Mitarbeiterpasswörtern und gibt hilfreiche Empfehlungen dazu, wie die Passwortsicherheit in Ihrem Unternehmen langfristig verbessert werden kann. Oftmals können hierdurch prozessuale Probleme, zum Beispiel beim Onboarding von Mitarbeitern oder Fehlkonfigurationen in Gruppenrichtlinien und Passwortrichtlinien aufgezeigt werden. Weiterhin besteht die Möglichkeit einen Passwort-Audit mit Nutzerbezug durchzuführen. Hierbei sind lediglich Sie als Kunde in der Lage, geknackte Passwort-Hashes abschließend auf Ihre Mitarbeiter zurückzuführen. Der Prozess eines nutzerbasierten Audits wird ebenfalls mit Ihrem Betriebsrat abgestimmt und folgt geltenden Datenschutzbestimmungen.

Statistiken aus durchgeführten Passwort-Audits

Seit der Gründung der Pentest Factory GmbH im Jahr 2019 konnten schon eine Vielzahl an Passwort-Audits für unsere Kunden durchgeführt und der Umgang mit Passwörtern verbessert werden. Neben technischen Fehlkonfigurationen, wie zum Beispiel eine nicht einheitlich angewandte Passwortrichtlinie, konnten oftmals prozessuale Probleme aufgezeigt werden. Insbesondere bei dem Onboarding von neuen Mitarbeitern entstehen oftmals unsichere Prozesse, die zu einer schwachen oder unsicheren Passwortwahl führen. Ebenso kommt es vor, dass administrative Nutzer ihre Passwörter unabhängig von den geltenden Richtlinien wählen können. Da diese Nutzer im Unternehmen hoch privilegiert sind, geht hierbei ein erhöhtes Risiko bei der Verwendung schwacher Passwörter einher. Sollte ein Angreifer in der Lage sein, das Passwort eines administrativen Nutzers zu erraten, so kann das komplette Unternehmen und seine IT-Infrastruktur kompromittiert werden.

Um Ihnen einen Einblick in unsere Arbeit zu geben, möchten wir Ihnen Statistiken zu den von uns durchgeführten Passwort-Audits vorstellen.

Über alle Audits hinweg konnten bislang 32.493 einzigartige Passwort-Hashes untersucht werden. Inklusive wiederverwendeter Passwörter kommen wir hier bereits auf eine Anzahl von 40.288 Passwort-Hashes. Dies bedeutet, dass insgesamt bereits 7795 Mitarbeiterpasswörter geknackt werden konnten, die mehrmals über mehrere Nutzerkonten wiederverwendet wurden. Dazu gehören oftmals Passwörter wie „Winter2021“ oder Passwörter, die initial an Mitarbeiter beim Onboarding vergeben und nicht geändert wurden. Die höchste Wiederverwendung eines einzelnen Passwortes war circa 450-mal. Hierbei handelte es sich um ein initial vergebenes Passwort, welches von vielen Nutzern nachträglich nicht geändert wurde.

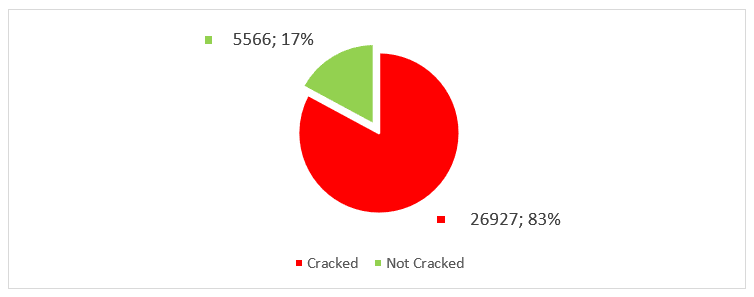

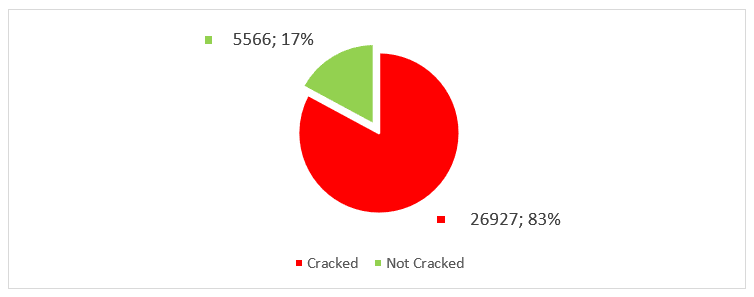

Von den insgesamt 32.493 einzigartigen Passwort-Hashes konnten während unserer Tests bereits 26.927 Klartextpasswörter zurückberechnet werden. Dies entspricht einem Prozentsatz von über 82%. Das bedeutet, dass wir in der Lage waren, deutlich mehr als zwei Drittel aller Mitarbeiterpasswörter bei Passwort-Audits zu brechen. Eine erschreckende Statistik.

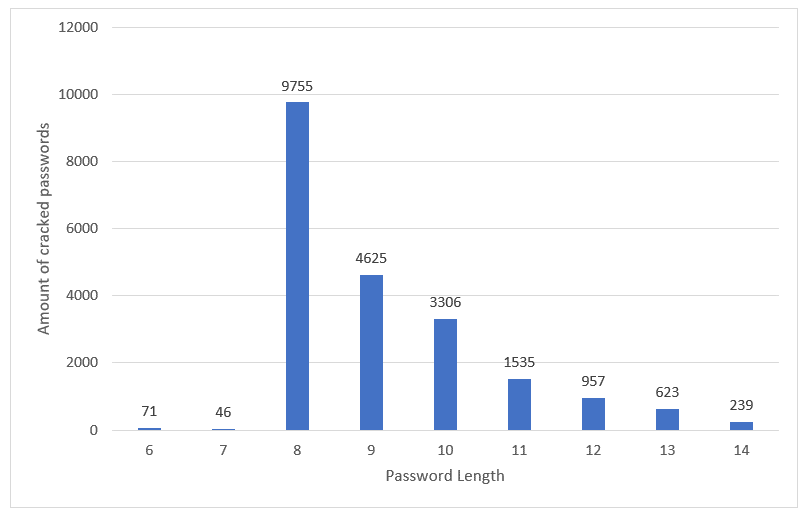

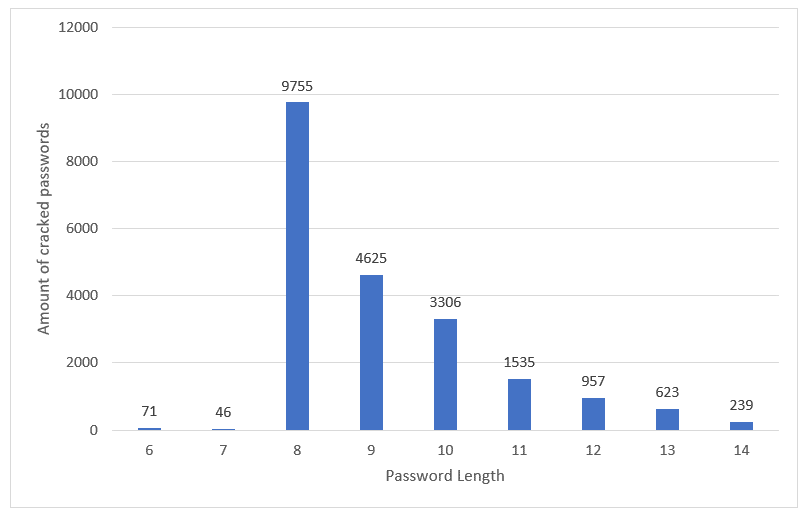

Dies ist hauptsächlich darauf zurückzuführen, dass Passwörter mit einer Passwortlänge kleiner 12 Zeichen zum Einsatz kamen bzw. zu schwach gewählt wurden. Die folgende Grafik unterstreicht unsere Erkenntnis.

Anmerkung: Das unten aufgeführte Schaubild beinhaltet nicht alle gebrochenen Passwortlängen. Einzelne Ausreißer, wie Passwortlängen über 20 Zeichen oder sehr kurze bis hin zu leere Passwörter, wurden in der Grafik zum Beispiel vernachlässigt.

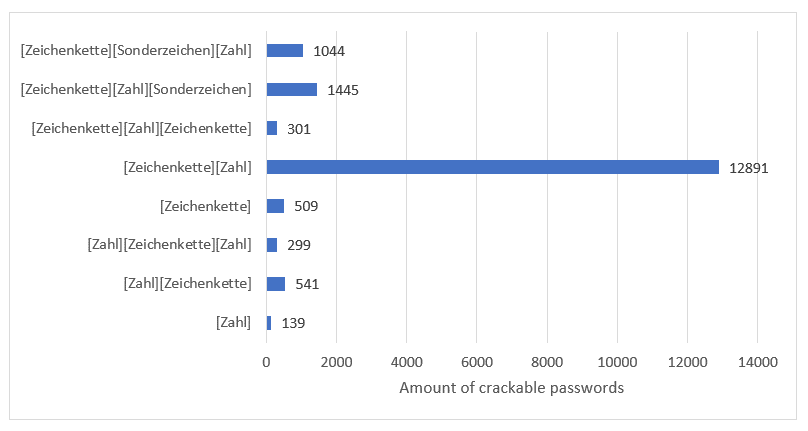

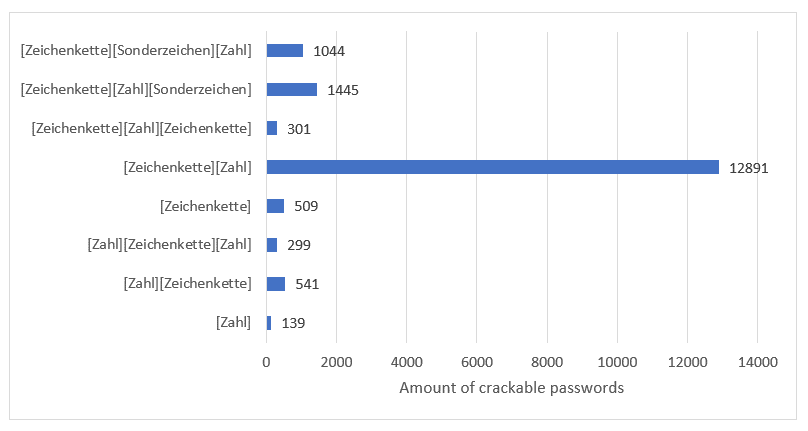

Weiterhin zeigen unsere Statistiken die Auswirkungen einer zu schwach gewählten oder fehlenden Passwortrichtlinie sowie Probleme bei der Anwendung der Richtlinie auf alle Nutzerkonten.

Anmerkung: Das unten aufgeführte Schaubild beinhaltet nicht alle Passwortmasken gebrochener Passwörter, sondern lediglich eine Auswahl.

Eine Vielzahl von Mitarbeiterpasswörtern waren demnach erratbar, da diese auf einer bekannten Passwortmaske beruhten. Über 12.000 geknackte Passwörter hatten hierbei einen Aufbau bestehend aus einer initialen Zeichenkette und einer abschließenden Verwendung numerischer Werte. Dazu gehören zum Beispiel äußerst schwache Passwörter wie „Sommer2019“ und „passwort1“.

Solche Passwörter stehen in der Regel bereits in öffentlich verfügbaren Passwortlisten zur Verfügung. Einer der bekanntesten Passwortlisten nennt sich „Rockyou“ und enthält über 14 Millionen einzigartige Passwörter aus einem ehemaligen Breach im Jahr 2009 der Firma RockYou. Die Firma wurde Opfers eines Hackerangriffs und speicherte alle Kundenpasswörter in einer Datenbank im Klartext. Die Hacker konnten auf diese Daten zugreifen und veröffentlichten den Datensatz im Nachhinein.

Auf Basis solcher Leaks ist es möglich, Statistiken zum Aufbau gewählter Nutzerpasswörter zu erstellen. Diese Statistiken, Muster und Regeln zum Passwortaufbau können anschließend verwendet werden, um eine Vielzahl neuer Passwort-Hashes effektiv zu brechen. Die Verwendung eines Passwortmanagers, der kryptografisch zufällige und komplexe Passwörter generiert, kann solche regelbasierten Angriffe oder wiederkehrende Muster erschweren bzw. verhindern.

Empfehlungen zur Passwort-Sicherheit

Unsere Statistiken haben gezeigt, dass die Wahl einer strikten und modernen Passwortrichtlinie die Erfolgswahrscheinlichkeit eines Cracking-Angriffes oder Rate-Versuchs drastisch vermindern kann. Jedoch basiert die Passwortsicherheit in einem Unternehmen auf mehreren Faktoren, welche wir gerne etwas erläutern.

Passwortlänge

Nehmen Sie Abstand von veralteten Passwortrichtlinien, die lediglich eine Passwortlänge von 8 Zeichen erfordern. Der Kostenaufwand für moderne, leistungsstarke Hardware sinkt stetig, wodurch auch Angreifer mit einem geringen Budget in der Lage sind, Passwort-Angriffe effektiv durchzuführen. Mit dem vermehrten Aufkommen kostengünstiger Cloudanbieter ist es weiterhin möglich, Angriffe flexibel mit einem fixen Budget durchzuführen, ohne effektiv Hardware kaufen oder Systeme aufsetzen zu müssen.

Bereits eine Passwortlänge von 10 Zeichen kann den Aufwand für einen Angreifer erheblich erhöhen, auch unter Verwendung moderner Cracking-Systeme. Für Unternehmen, die Microsoft Active Directory einsetzen, empfehlen wir jedoch den Einsatz einer Passwortrichtlinie, die eine Passwortlänge von mind. 12 Zeichen technisch erfordert.

Komplexität

Stellen Sie weiterhin sicher, dass Passwörter eine ausreichende Komplexität besitzen und aus den folgenden Mindestanforderungen bestehen:

- Passwort enthält mind. einen Kleinbuchstaben

- Passwort enthält mind. einen Großbuchstaben

- Passwort enthält mind. eine Zahl

- Passwort enthält mind. ein Sonderzeichen

Regelmäßige Passwortwechsel

Das regelmäßige Wechseln von Passwörtern wird vom BSI nicht mehr empfohlen, solange das Passwort lediglich autorisierten Personen zugänglich bzw. bekannt ist. [4]

Sollte das Passwort jedoch kompromittiert worden sein, also einer nicht autorisierten Person bekannt sein, so muss sichergestellt werden, dass das Passwort umgehend geändert wird. Weiterhin ist es ratsam, öffentliche Datenbanken bezüglich neuer Passwort-Leaks Ihres Unternehmens regelmäßig zu überprüfen. Gerne unterstützen wir Sie mit einem Cyber Security Check hierbei.

Passwort-Historie

Stellen Sie sicher, dass Nutzer bei dem Passwortwechsel keine bereits zuvor verwendeten Passwörter wählen können. Implementieren Sie hierzu eine Passwort-Historie, die die letzten 24 Nutzerpasswörter beinhaltet und deren Wiederverwendung verhindert.

Einsatz von Blacklisten

Implementieren Sie zusätzliche Checks bei der Passwortänderung, um die Verwendung bekannter Blacklist-Wörter zu unterbinden. Dazu gehört zum Beispiel der eigene Unternehmensname, die Jahreszeiten, der Name von Dienstleistern oder Produkten bis hin zu einzelnen Wörtern wie „Passwort“. Stellen Sie sicher, dass diese Blacklist-Wörter technisch unterbunden werden und nicht nur organisatorisch verboten werden.

Automatische Kontosperrung

Konfigurieren Sie eine automatische Kontosperrung bei mehrmaligen Fehlanmeldungen, um Online-Angriffe aktiv abzuwehren. Eine bewährte Richtlinie lautet, das Nutzerkonto nach 5 fehlgeschlagenen Logins für 5-10 Minuten zu sperren. Gesperrte Konten sollten nach einer fest definierten Zeitspanne automatisiert entsperrt werden, um einen Regelbetrieb zu ermöglichen und Help-Desk-Überlastungen zu vermeiden.

Sensibilisierung

Die Sensibilisierung aller Mitarbeiter, inklusive des Managements, ist essenziell wichtig, um das Sicherheitslevel gesamtflächig anzuheben. Regelmäßige Sensibilisierungsmaßnahmen sollten ein Bestandteil der Unternehmenskultur werden, um den korrekten Umgang mit sensitiven Zugangsdaten zu unterrichten.

Es bedarf einer bewussten Verhaltensänderung aller Mitarbeiter in sicherheitsrelevanten Situationen, zum Beispiel:

- Den PC sperren, auch wenn man nur kurz den Arbeitsplatz verlässt;

- Vertrauliche Unterlagen wegsperren;

- Niemandem sein Passwort weitergeben;

- Verwendung von sicheren (starken) Passwörtern;

- Passwörter nicht doppelt bzw. mehrfach verwenden.

Trotz einer technisch strikten Passwortrichtlinie können Nutzer noch immer schwache Passwörter wählen, die relativ einfach erraten werden können. Lediglich die Durchführung regelmäßiger Passwortaudits und die Sensibilisierung von Mitarbeitern kann dies langfristig verhindern.

Verwendung von 2 Faktor-Authentifizierung

Konfigurieren Sie zusätzliche Sicherheitsmaßnahmen wie beispielsweise die Zwei-Faktor-Authentifizierung. Dies stellt sicher, dass selbst im Falle eines erfolgreichen Passwort-Rate-Versuchs, ein Angreifer ohne Besitz eines zweiten Tokens keinen Zugriff auf das Nutzerkonto und Unternehmensressourcen erhält.

Regelmäßige Passwort-Audits

Führen Sie regelmäßige Passwort-Audits durch, um Nutzerkonten mit schwachen oder wiederverwendeten Passwörtern zu identifizieren und diese vor zukünftigen Angriffen abzusichern. Durch eine beständige Re-Evaluierung Ihrer unternehmensweiten Passwortrichtlinie und Effektivität von Awareness-Schulungen auf technischer Ebene können sie Kennzahlen generieren, um die Passwortsicherheit in Ihrem Unternehmen zu messen und kontinuierlich zu verbessern.

Differenzierte Passwortrichtlinien

Führen Sie mehrere Passwortrichtlinien in Ihrem Unternehmen ein, basierend auf dem Schutzbedarf der darauf angewandten Zielgruppe. Niedrig privilegierte Nutzerkonten können so zum Beispiel technisch gezwungen werden, eine Passwortlänge von 12 Zeichen inkl. Komplexitätsanforderungen einzuhalten, während administrative Nutzerkonten eine striktere Richtlinie mit mind. 14 Zeichen befolgen müssen.

Zusätzliche Sicherheitsfeatures

Gerne beraten wir Sie zu zusätzlichen Sicherheitseinstellungen in Ihrer Active Directory Umgebung, um die Passwortsicherheit zu verbessern. Dazu gehören unter anderem:

- Local Administrator Password Solution (LAPS)

- Custom .DLL Password Filters

- Logging und Monitoring von Active Directory Events

Beauftragung

Sollten wir Ihr Interesse an der Durchführung eines Passwort-Audits wecken können, so freuen wir uns über eine Kontaktaufnahme Ihrerseits. Gerne unterstützen wir Sie dabei, die Passwortsicherheit in Ihrem Unternehmen zu überprüfen sowie langfristig zu verbessern.

Verwenden Sie gerne unseren Online-Konfigurator zur Beauftragung eines Audits.

Weitere Informationen zum Passwort-Audit finden Sie unter: https://www.pentestfactory.de/passwort-audit

Quellen

[1] https://hpi.de/news/jahrgaenge/2020/die-beliebtesten-deutschen-passwoerter-2020-platz-6-diesmal-ichliebedich.html

[2] https://www.kas.de/documents/252038/7995358/Die+Auswirkungen+von+COVID-19+auf+Cyberkriminalit%C3%A4t+und+staatliche+Cyberaktivit%C3%A4ten.pdf/8ecf7084-704b-6810-4374-5840a6954b9f?version=1.0&t=1591354253482

[3] https://hpi.de/news/jahrgaenge/2020/die-beliebtesten-deutschen-passwoerter-2020-platz-6-diesmal-ichliebedich.html#:~:text=Das%20Hasso%2DPlattner%2DInstitut%20(,sind%20und%202020%20geleakt%20wurden.

[4] https://www.bsi.bund.de/SharedDocs/Downloads/DE/BSI/Grundschutz/Kompendium/IT_Grundschutz_Kompendium_Edition2020.pdf – Punkt ORP.4.A8

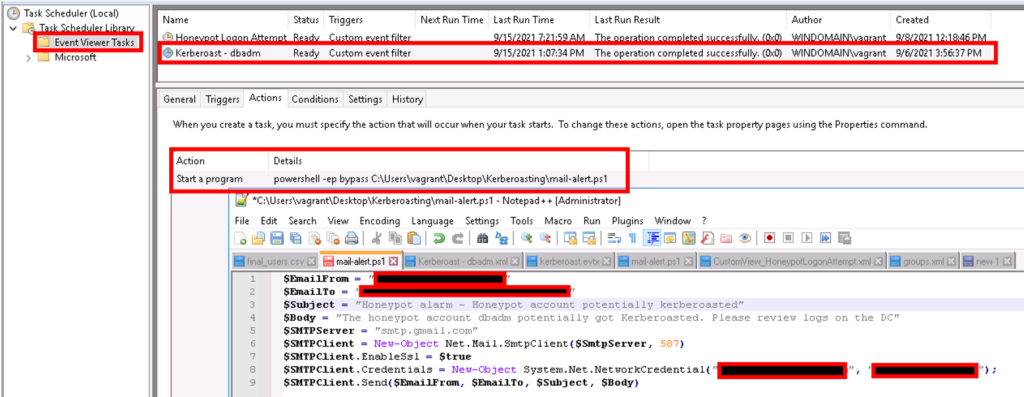

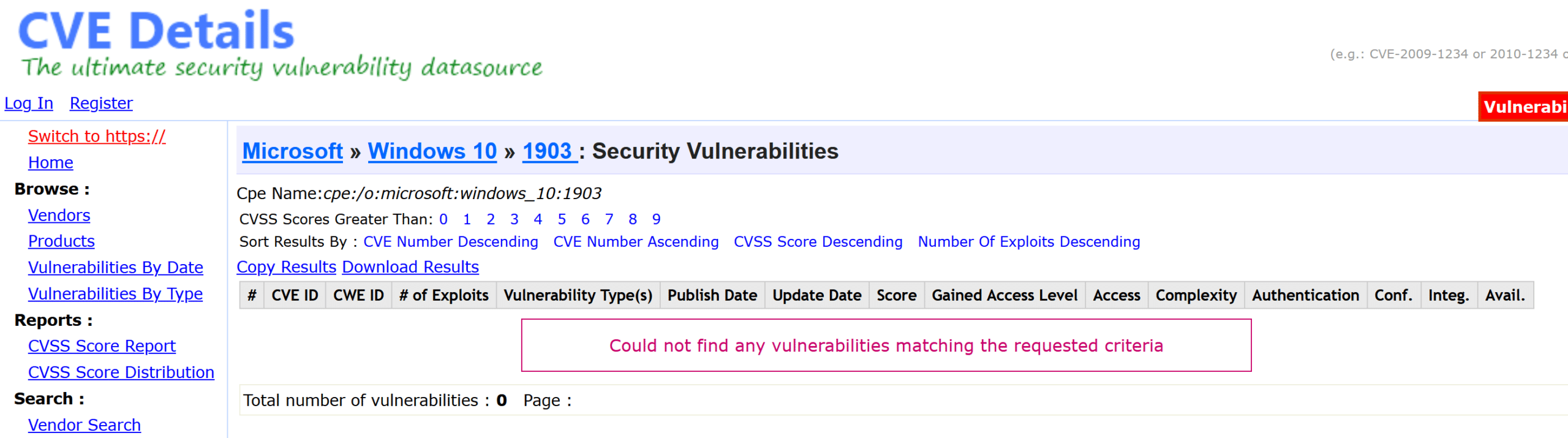

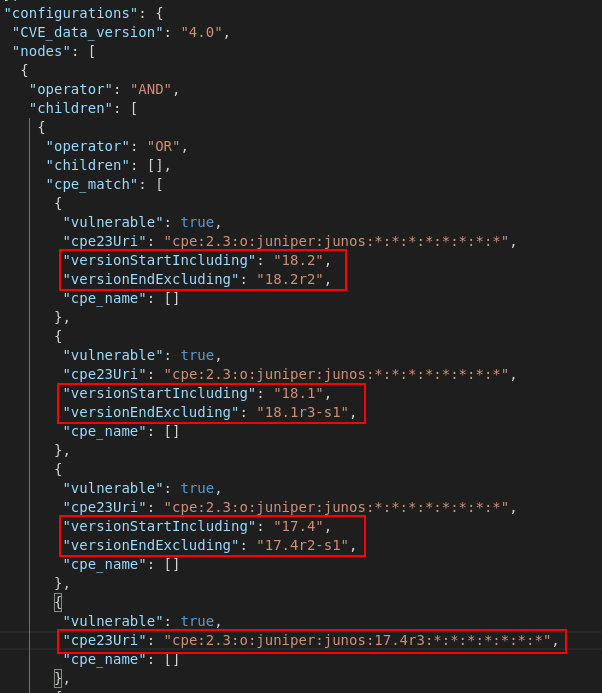

Abbildung: Fehlerhafte Schwachstelleninfos für Windows 10

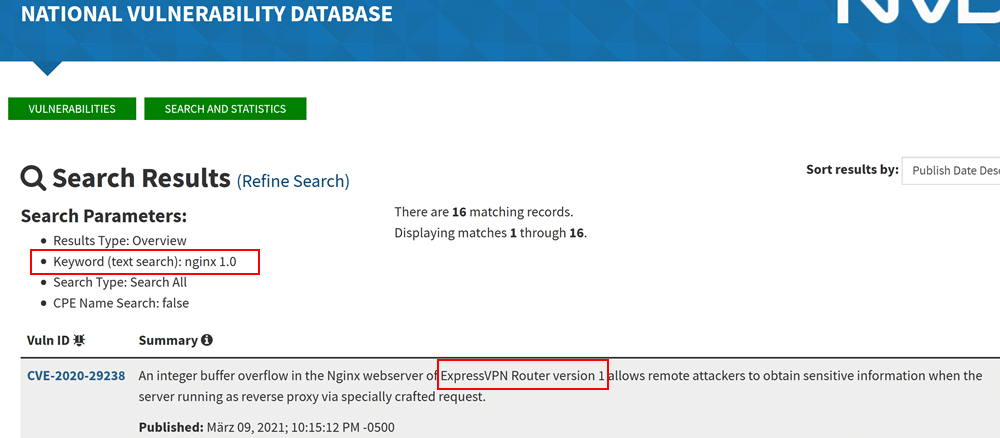

Abbildung: Fehlerhafte Schwachstelleninfos für Windows 10 Abbildung: Stichwortsuche zeigt anderes Produkt als das eigentlich gesuchte

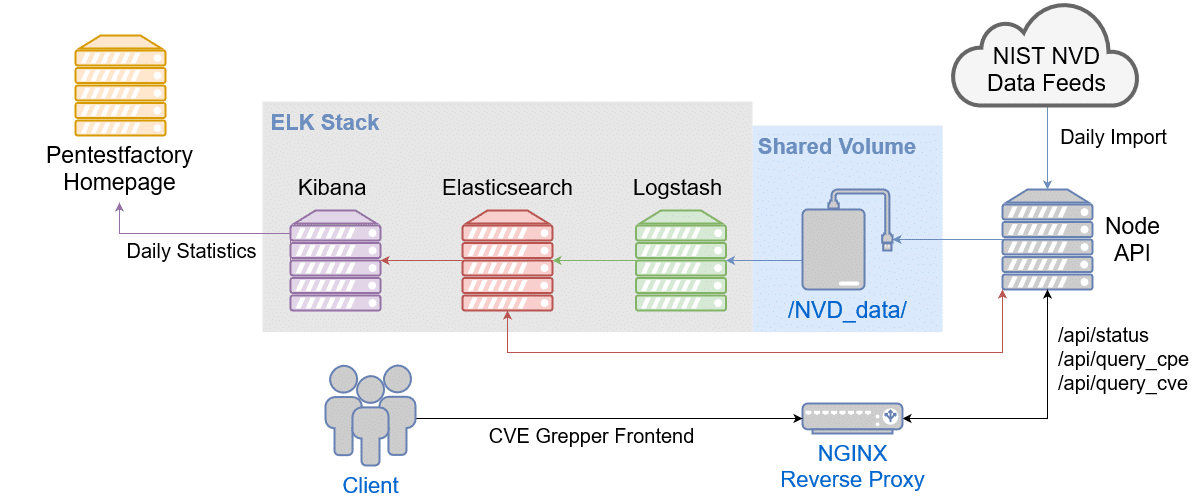

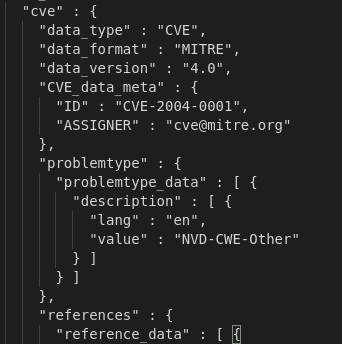

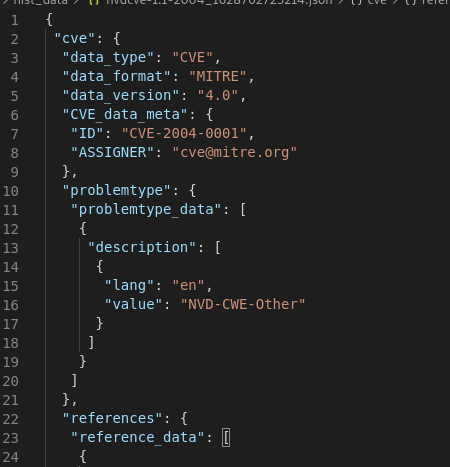

Abbildung: Stichwortsuche zeigt anderes Produkt als das eigentlich gesuchte Abbildung: Überblick der technischen Komponenten unserer Schwachstellendatenbank

Abbildung: Überblick der technischen Komponenten unserer Schwachstellendatenbank

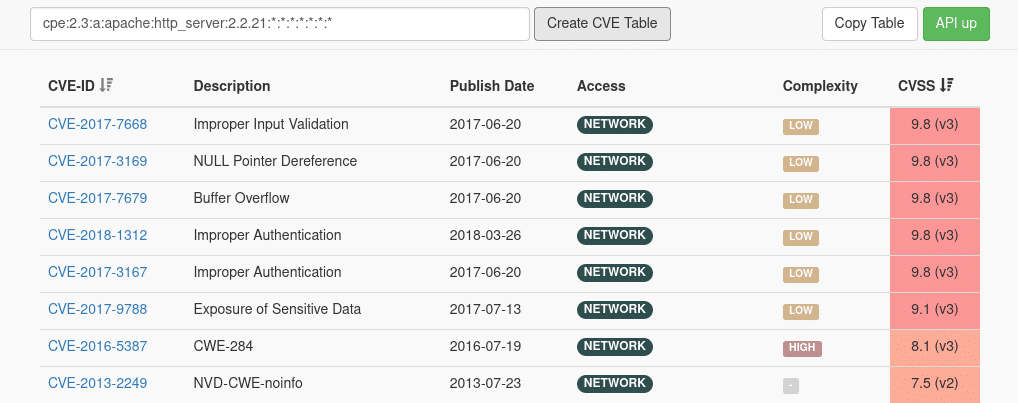

Abbildung: Vorschau unseres Schwachstellen-Suche Frontends

Abbildung: Vorschau unseres Schwachstellen-Suche Frontends

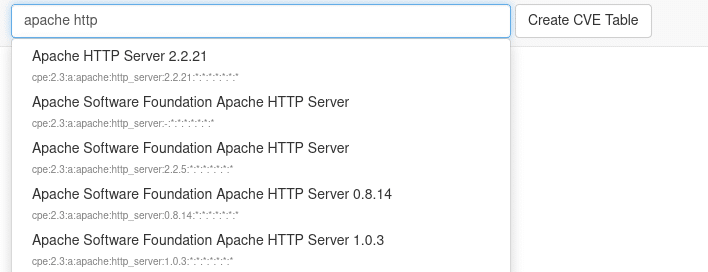

Abbildung: Autocomplete-Funktion des Such-Frontends

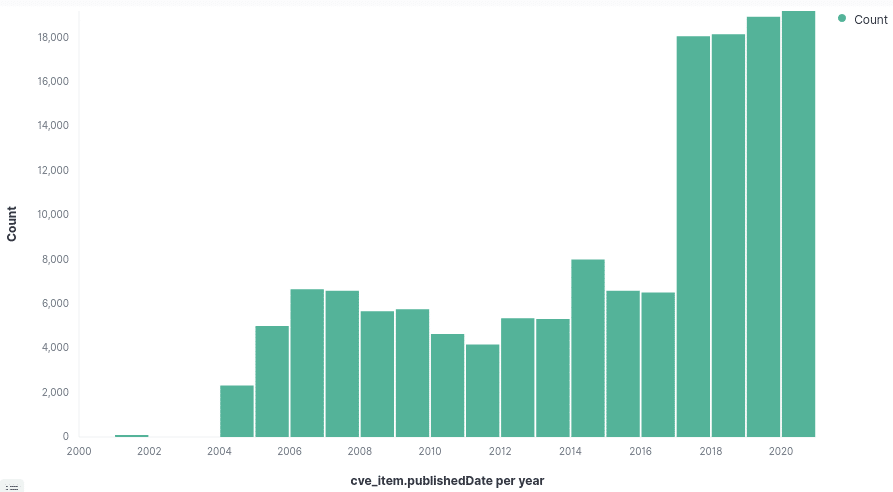

Abbildung: Autocomplete-Funktion des Such-Frontends Abbildung: Anzahl der registrierter Schwachstellen pro Jahr

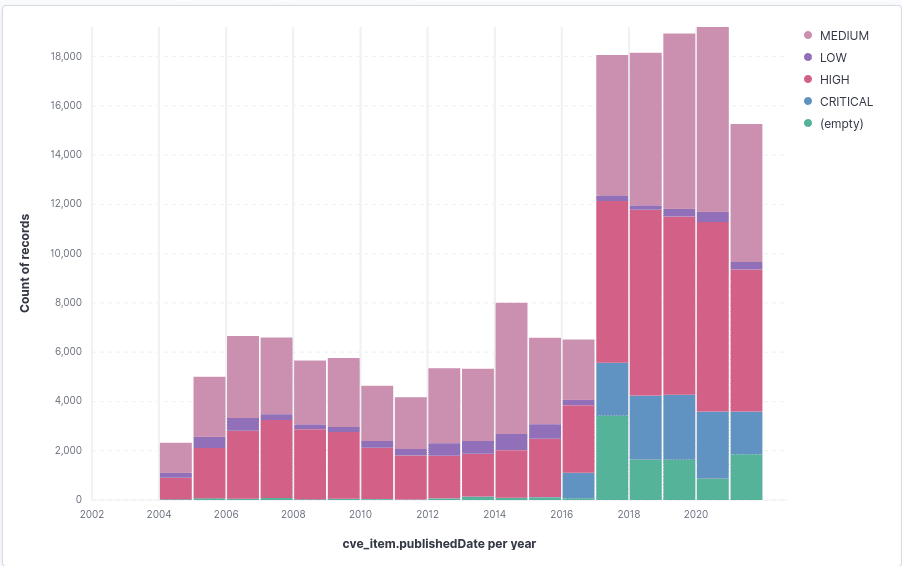

Abbildung: Anzahl der registrierter Schwachstellen pro Jahr Abbildung: Anteile der jeweiligen Risikobewertungsgruppen pro Jahr

Abbildung: Anteile der jeweiligen Risikobewertungsgruppen pro Jahr

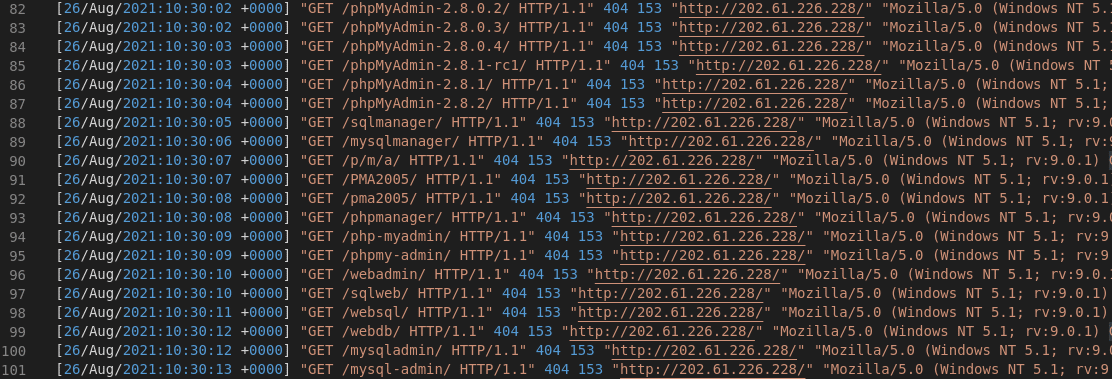

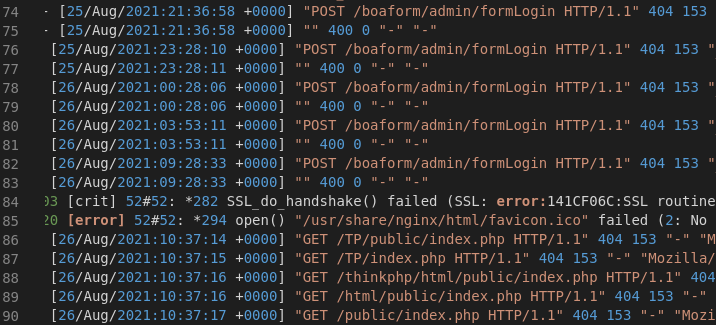

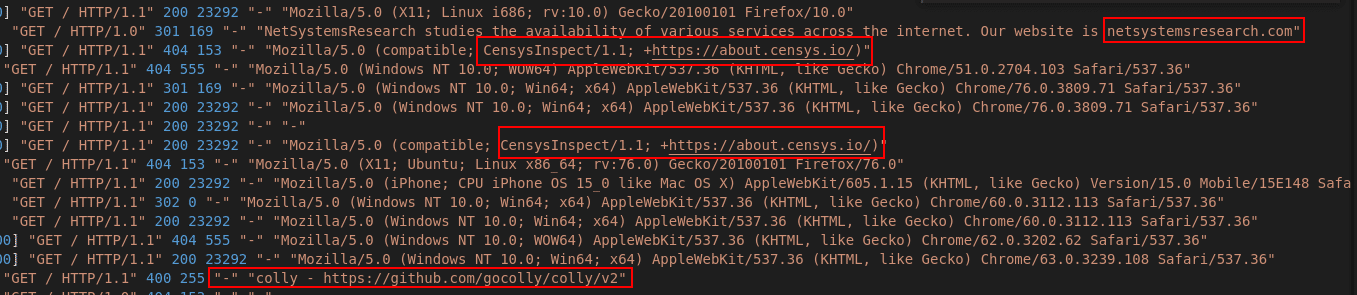

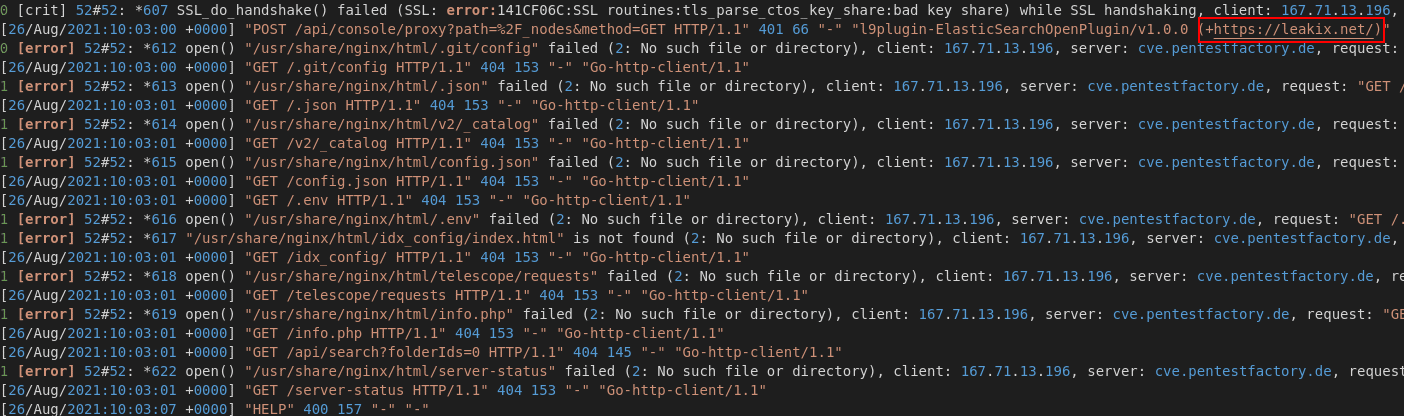

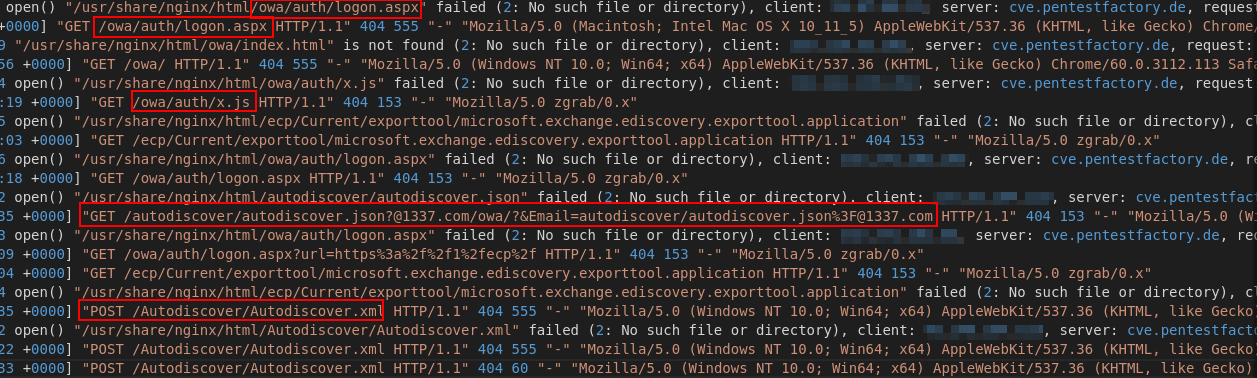

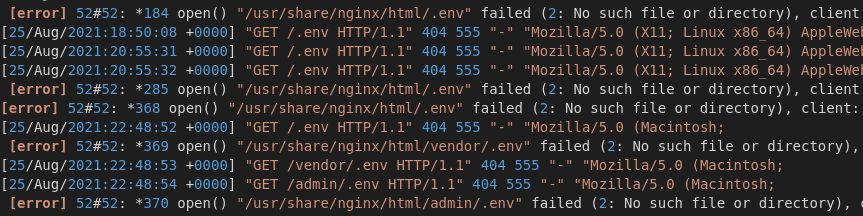

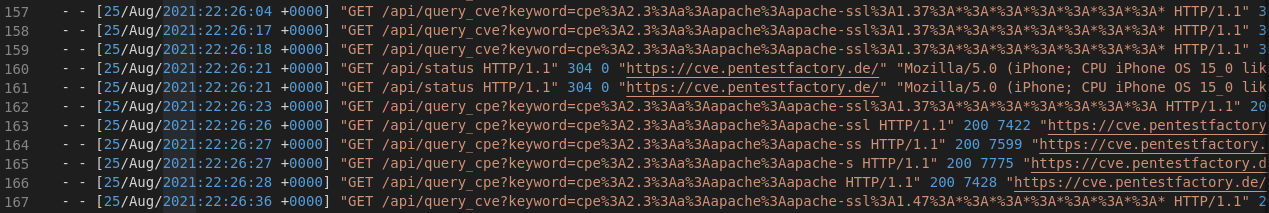

Abbildung 1: Auszug legitimer Anfragen an den Webserver

Abbildung 1: Auszug legitimer Anfragen an den Webserver